템플릿 매칭의 진화: 픽셀 기반에서 딥러닝까지

두 이미지에서 같은 물체를 찾으려면 어떻게 해야 할까요? 가장 단순한 방법은 픽셀을 직접 비교하는 것입니다. 하지만 조명이 바뀌거나 카메라 각도가 달라지면 실패합니다.

이 글에서는 템플릿 매칭 기술이 픽셀 기반 → Hand-crafted Features → 딥러닝으로 발전해온 과정을 설명합니다.

발전 단계 요약

| 단계 | 대표 기술 | 특징 | 한계 |

|---|---|---|---|

| 1단계 | SSD, SAD, NCC | 픽셀 직접 비교 | 크기/회전/조명 변화에 취약 |

| 2단계 | SIFT, ORB | Hand-crafted 특징점 | 텍스처 없는 영역, 반복 패턴에 취약 |

| 3단계 | SuperPoint | 딥러닝 특징점 검출 | 매칭은 여전히 전통 방식 |

| 4단계 | SuperGlue | 딥러닝 특징점 매칭 | GPU 필요 |

1단계: 픽셀 기반 템플릿 매칭

템플릿 이미지를 대상 이미지 위에서 슬라이딩하며 유사도를 계산합니다.

유사도 측정 방법

| 방법 | 수식 | 특징 |

|---|---|---|

| SSD (Sum of Squared Differences) | 낮을수록 유사 | |

| SAD (Sum of Absolute Differences) | SSD보다 계산 빠름 | |

| NCC (Normalized Cross-Correlation) | 정규화 상관계수 | 밝기 변화에 강건 |

OpenCV 구현: cv2.matchTemplate()

픽셀 기반의 한계

- 크기 변화: 템플릿과 대상의 크기가 다르면 실패

- 회전 변화: 회전된 물체 인식 불가

- 조명 변화: 밝기가 달라지면 유사도 저하

- 가림(Occlusion): 일부가 가려지면 실패

2단계: Hand-crafted Features

픽셀 대신 특징점(Keypoint)을 추출하여 비교합니다.

SIFT (2004)

Scale-Invariant Feature Transform

- 스케일 공간 구축: DoG(Difference of Gaussian) 피라미드

- 키포인트 검출: 로컬 극대/극소점

- 디스크립터 생성: 그래디언트 히스토그램 기반 128차원 벡터

달성: 크기 불변성, 회전 불변성

SIFT 이후의 속도 개선 시도들

SIFT는 정확하지만 느렸습니다. 이를 개선하기 위한 여러 시도가 있었습니다:

| 알고리즘 | 연도 | 핵심 아이디어 | 한계 |

|---|---|---|---|

| SURF | 2006 | Hessian 기반 검출 + Integral Image로 SIFT 대비 수 배 빠름 | 특허 문제 |

| BRIEF | 2010 | Binary descriptor 도입, 픽셀 쌍 비교만으로 디스크립터 생성 | 회전 불변성 없음 |

| BRISK | 2011 | BRIEF를 스케일 불변으로 확장 | 여전히 속도 한계 |

이러한 시도들을 종합하여 ORB가 등장합니다.

ORB (2011)

Oriented FAST and Rotated BRIEF

| 구성 요소 | 설명 |

|---|---|

| FAST | 코너 검출기 + 피라미드로 스케일 처리 |

| rBRIEF | 회전 불변 이진 디스크립터 |

| 매칭 | Hamming 거리 (XOR 연산) |

장점:

- SIFT/SURF 대비 수십 배 빠름

- 특허 없음

- 실시간 SLAM/AR의 사실상 표준

Hand-crafted Features의 한계

- 텍스처 없는 영역: 특징점 검출 실패

- 반복 패턴: 유사한 특징점이 많아 오매칭

- 극단적 조명 변화: 디스크립터 변형

3단계: 딥러닝 특징점 검출 - SuperPoint (2018)

MagicLeap에서 개발한 Self-supervised 학습 기반 특징점 검출기.

학습 방법

문제: 특징점의 Ground Truth 라벨을 어떻게 얻을 것인가?

해결책: 2단계 학습

| 단계 | 이름 | 방법 |

|---|---|---|

| 1단계 | MagicPoint | 합성 이미지(선, 삼각형, 사각형)에서 코너/교차점을 GT로 학습 |

| 2단계 | Homographic Adaptation | 실제 이미지에 여러 호모그래피 변환 적용 → 검출된 키포인트 누적 |

네트워크 출력

단일 CNN이 두 가지를 동시에 출력:

- 키포인트 확률 맵: 각 픽셀이 키포인트일 확률

- Dense 디스크립터 맵: 256차원 디스크립터

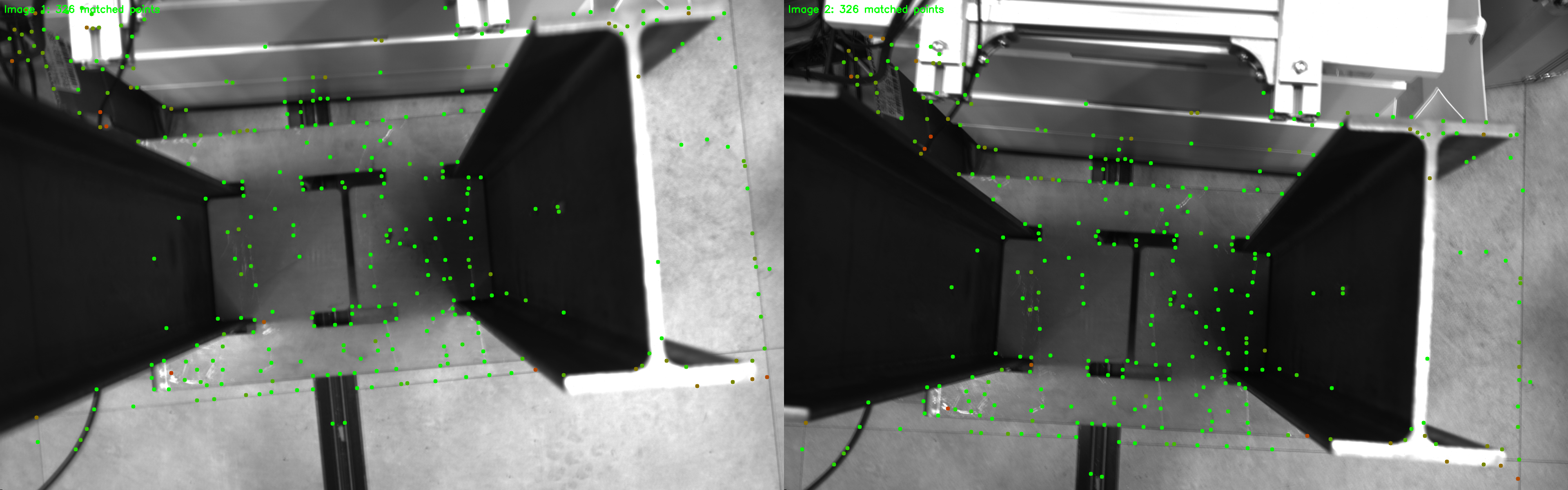

SuperPoint 키포인트 검출 결과

두 이미지에서 SuperPoint로 검출한 키포인트 (녹색 점). 텍스처가 풍부한 영역에 집중

관찰:

- 금속 구조물의 에지와 코너에 키포인트 집중

- 텍스처 없는 영역(벽, 바닥)은 자동으로 회피

- 의미 있는 특징점만 선택적으로 검출

4단계: 딥러닝 특징점 매칭 - SuperGlue (2020)

MagicLeap에서 개발한 Graph Neural Network 기반 매칭 네트워크.

기존 매칭의 문제

전통적인 매칭 파이프라인:

최근접 이웃 → Ratio Test → RANSAC (아웃라이어 제거)

한계:

- 반복 패턴에서 오매칭 다수

- RANSAC에 의존하여 후처리 필요

- 컨텍스트 정보 미사용

SuperGlue의 접근법

매칭을 그래프 문제로 정의:

- 키포인트 인코딩: 위치 + 시각적 디스크립터

- Self-Attention: 같은 이미지 내 관계 학습

- Cross-Attention: 두 이미지 간 관계 학습

- L iterations: Attentional GNN 레이어 반복

Optimal Transport (Sinkhorn)

최종 매칭에 Optimal Transport 알고리즘 적용:

- 각 키포인트는 최대 하나의 상대와 매칭

- Dustbin 개념: 매칭 불가능한 점(가림, 단일 뷰) 명시적 처리

SuperGlue 매칭 결과

SuperGlue로 매칭된 키포인트 쌍 (455, 542 키포인트에서 326 매칭). 색상은 매칭 신뢰도

관찰:

- 기하학적 일관성: 거의 모든 매칭 선이 일관된 방향

- 교차 선 없음: 아웃라이어가 극히 적음

- Dustbin 작동: 모든 키포인트가 매칭되지 않음 (가림 영역 처리)

방법 비교

속도 vs 정확도

속도: ORB >>>>>> SIFT > SuperPoint > SuperPoint+SuperGlue

정확도: ORB < SIFT < SuperPoint < SuperPoint+SuperGlue

용도별 권장사항

| 용도 | 권장 방법 | 이유 |

|---|---|---|

| 실시간 (30fps+) | ORB | 속도 우선, GPU 불필요 |

| 모바일/엣지 | ORB 또는 경량 SuperPoint | 리소스 제약 |

| 최대 정확도 | SuperPoint + SuperGlue | 딥러닝 정밀도 |

| 극단적 조명 변화 | SuperPoint + SuperGlue | 학습 기반 강건성 |

| 반복 패턴 | SuperGlue 필수 | 컨텍스트 기반 구별 |

| 빠른 프로토타이핑 | SIFT/ORB | OpenCV 내장, 쉬운 설정 |

응용 분야

| 분야 | 관련 기술 |

|---|---|

| Visual SLAM | 카메라 위치 추정 |

| AR 트래킹 | 가상 객체 정합 |

| 3D 재구성 | 다시점 이미지에서 구조 복원 |

| 이미지 스티칭 | 파노라마 생성 |

| 로봇 내비게이션 | 환경 인식 |

| 산업 검사 | 결함 검출 |

핵심 정리

-

픽셀 기반 매칭은 크기, 회전, 조명 변화에 취약합니다. 단순한 환경에서만 사용 가능합니다.

-

SIFT는 스케일/회전 불변성을 달성했지만 계산이 느립니다. ORB는 수십 배 빠르면서 특허가 없어 실시간 SLAM의 표준이 되었습니다.

-

SuperPoint는 Self-supervised 학습으로 라벨링 문제를 해결하고, 의미 있는 특징점만 검출합니다.

-

SuperGlue는 GNN + Optimal Transport로 컨텍스트 기반 매칭을 수행합니다. RANSAC 없이도 아웃라이어가 적고, Dustbin으로 매칭 불가능한 점을 명시적으로 처리합니다.

-

선택 기준:

- 실시간 필요 → ORB

- 최대 정확도 필요 → SuperPoint + SuperGlue

- 반복 패턴 환경 → SuperGlue 필수

템플릿 매칭은 "어디에서나 통하는" 범용 기술입니다. 문제의 요구사항에 맞는 방법을 선택하세요.